Информации теория

ИНФОРМАЦИИ ТЕОРИЯ, раздел математики, исследующий процессы хранения, преобразования и передачи информации. Информации теория - часть кибернетики. В основе информации теории лежит определённый способ измерения количества информации, содержащейся в каких-либо данных (сообщениях).

Информации теория исходит из представления о том, что сообщения, предназначенные для сохранения в запоминающем устройстве или для передачи по каналу связи, не известны заранее с полной определённостью. Заранее известен лишь источник сообщений, то есть множество х1, х2, ..., xn, из которого могут быть выбраны эти сообщения, вероятности р1, р2, ..., рn появления этих сообщений. В информации теории неопределённость, с которой сталкиваются в подобной обстановке, допускает количественное выражение, и именно это количество, а не конкретная природа самих сообщений, определяет возможность их хранения и передачи. Рассматриваются всевозможные способы записи сообщений цепочками символов 0 и 1, называемые двоичными кодами, удовлетворяющие условиям: а) различным сообщениям соответствуют различные цепочки; б) по записи любой последовательности сообщений в кодированной форме эта последовательность должна однозначно восстанавливаться. В качестве меры неопределённости источника сообщений принимают среднее значение длины кодовой цепочки, соответствующее самому экономному способу кодирования; единицей измерения служит один двоичный знак.

Реклама

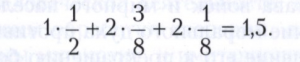

Пример. Пусть некоторые сообщения х1, х2, х3 появляются с вероятностями, равными соответственно 1/2, 3/8, 1/8. Какой-либо короткий код, например, х1 = 0, х2 = 1, х3 = 01, не пригоден, так как нарушается условие б), поскольку цепочка 01 может означать как х1, х2, так и х3. Код х1 = 0, х2 = 10, х3 = 11 удовлетворяет условиям а) и б). Ему соответствует среднее значение длины кодовой цепочки, равное

Оказывается, что никакой другой код не может дать меньшего значения, то есть указанный код - самый экономный, мера неопределённости данного источника сообщений равна 1,5 (двоичных знаков).

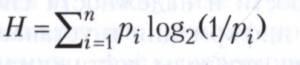

Не существует простой формулы, выражающей точный минимум Н’ среднего числа двоичных знаков, необходимых для кодирования сообщений х1, х2, ..., хn, через вероятности р1, р2, ..., рn этих сообщений. Однако этот минимум не меньше величины

и может превосходить её не более чем на единицу. Величина Н, называемая энтропией источника сообщений, обладает простыми свойствами, а для всех выводов информации теории, которые носят асимптотический характер, то есть соответствуют случаю Н’ → ∞, различие между Н и Н’ несущественно. Поэтому именно энтропия принимается в качестве меры неопределённости данного источника. В приведённом выше примере энтропия равна

![]()

Энтропия бесконечной совокупности сообщений х1, х2, появляющихся с вероятностями р1, р2, ..., оказывается, как правило, бесконечной, поэтому в применении к источникам с бесконечным числом сообщений поступают иначе. Именно, задаются определённым уровнем точности и вводят понятие ε-энтропии как энтропии сообщения, записываемого с точностью до ε, если сообщение представляет собой непрерывную величину или функцию, например, времени.

Так же, как и понятие энтропии, понятие количества информации, содержащейся в одном случайном объекте (случайной величине, случайном векторе, случайной функции и т.д.) относительно другого, вводится сначала для объектов с конечным числом n возможных значений. Затем общий случай изучается при помощи предельного перехода при n → ∞. В отличие от энтропии количество информации, например, в одной непрерывно распределённой случайной величине относительно другой непрерывно распределённой величины, часто оказывается конечным.

Понятие канала связи в информации теории носит весьма общий характер. Канал связи задаётся указанием множества допустимых сообщений на входе канала, множеством сообщений на выходе и набором условных вероятностей получения того или иного сообщения на выходе при данном входном сообщении. Эти условные вероятности описывают влияние помех, искажающих передаваемые сообщения. Присоединяя к каналу связи источник сообщений, можно рассчитать количество информации относительно сообщения на входе, содержащееся в сообщении на выходе. Верхняя грань таких количеств информации, взятая по всем допустимым источникам, называется пропускной способностью (ёмкостью) канала. Пропускная способность канала - его основная информационная характеристика. Несмотря на влияние (быть может, сильное) помех в канале, при определённом соотношении между энтропией поступающих сообщений и пропускной способностью канала при надлежащем кодировании возможна почти безошибочная передача сообщений.

В информации теории изучаются оптимальные в смысле скорости и надёжности способы передачи информации и устанавливаются теоретические пределы достижимого качества. Информации теория носит существенно вероятностный характер, и значительная часть её математических методов заимствуется из теории вероятностей.

Основы информации теории были заложены в 1948-1949 годах К. Шенноном. Её теоретические разделы разрабатывались А. Н. Колмогоровым и А. Я. Хинчиным, а разделы, связанные с применениями, - В. А. Котельниковым.

Литературу смотри при статье Информация.

Ю. В. Прохоров.